Carol Weiss.

Weiss es una socióloga estadounidense, profesora de la Harvard Graduate School of Education; para quien su enfoque en la evaluación parte de que los proyectos, programas, políticas e intervenciones son decisiones políticas, por tanto su evaluación contribuye a la toma de decisiones.

Los resultados de una evaluación van a entrar en la arena política porque el juicio de valor que se emite al evaluar es ya de por sí una posición política. Cualquier medición sobre los efectos de una evaluación deberían ir enfocados a la toma de decisiones y a la mejora futura.

Las consideraciones políticas de una evaluación provienen de tres frentes:

- Las políticas, programas y proyectos son producto de decisiones políticas y sujeta a sus presiones.

- Los resultados de una evaluación juegan un papel en la toma de decisiones y por tanto entran a competir con otros pesos políticos.

- Por lo anterior, sus juicios de valor pueden generar cambios en la dinámica de poder, en las acciones y decisiones que se tomen.

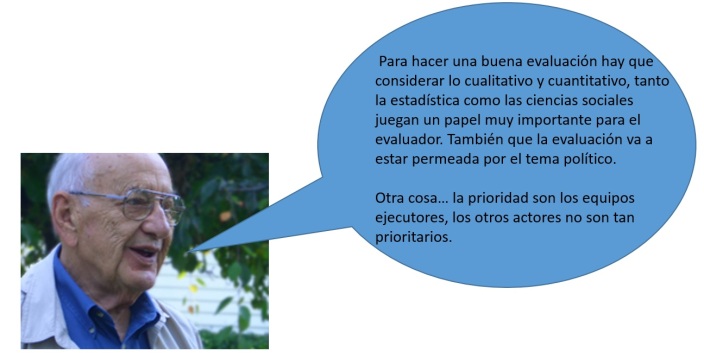

Shahidur R. Khandker

Para Khandker existen 3 tipo de evaluación:

- El monitoreo o seguimiento de indicadores claves, que permite verificar si se están generando efectos.

- La evaluación operacional, que permite examinar la eficacia para alcanzar los objetivos/resultados; y

- La evaluación de impacto

La 1era y la 2da, se debe hacer siempre; la evaluación de impacto no necesariamente, la misma solo debería hacerse si el programa es innovador y de importancia estratégica.

Khandker considera que el ejercicio de evaluar el impacto contribuye a disminuir a brecha de conocimiento sobre los aspectos que funcionas o no en una intervención, entre otras cosas sirve para:

- Sirven para conocer los verdaderos efectos e impactos

- Mejorar la distribución de recursos

- Conocer que estrategias funcionan mejor

- Determinar cuánto en el ¨cambio de bienestar¨ es atribuible al proyecto o programa.

- Determinar la efectividad mediante la generación de evidencia y datos duros.

Para este autor, el enfoque cuantitativo es de gran importancia, pero afirma que un enfoque cualitativo permite obtener información valiosa que dará una una visión más amplia del objeto evaluado, por lo que el autor prefiere un enfoque mixto.

Problema contra-factual: determinar que hubiese existido si el programa no hubiera existido, para saber eso hay que crear esa información con la que no se cuenta y de esta forma conocer qué hubiera pasado sí… Para esto hay que crear un grupo que represente un grupo contra-factual (grupo de control) Según el autor, solo con un contra-factual se pueden mostrar los resultados reales del impacto.

YVONNA LINCOLN y EGON GUBA: Modelo de cuarta generación

Consideran que la evaluación ha ido evolucionando hacia varios estadios:

1era generación: el enfoque centrado en el método/medición

2da generación: la evaluación se enfoca en medir y describir

3ra. Generación: incorpora juicios de valor al ordenar e interpretar la información

4ta. Generación: integra lo de sus generaciones predecesoras, busca que el proceso evaluativo sea construido con los stakeholder y trata de generar un conceso; es decir, el constructivismo en la evaluación. Agrupa la evaluación responsiva de Stake + metodologías naturalistas(etnográficas) = 4ta generación

Utiliza el método de círculos dialécticos hermenéuticos como espacios de diálogo intersubjetivo, donde el criterio se forma a partir de muchas intersubjetividades, de ahí se obtienen consensos y disensos. El papel del evaluador será aquí el de facilitador de consensos.

Peter H. Rossi, es un sociólogo estadounidense, profesor emérito en la University of Massachusetts, Amherst, Él considera el rol del evaluador como conciliador, mediador, comunicador, líder y pone énfasis en el método.

Introduce la concepción de que existen tres tipos de evaluación:

- Comprehensive evaluation/Evaluación total, conlleva tres tipos de actividades:

- análisis de la conceptualización y del diseño de la una intervención

- Necesidad de un control de implementación del programa.

- Evaluación de la utilidad, si queremos que el programa tenga continuidad.

2. Tailored evaluation/evaluación a la medida (surgen de aquí las visiones de evaluación ex-ante, durante y ex-post.

Este es uno de sus grandes aportes de Peter H. Rossi, pues no se puede evaluar todo igual según Rossi, los estándares aquí no aplican. Los proyectos o programas pueden ser nuevos/innovadores; estables y reformadores/modificadores. Cada estadio o nivel determina las cuestiones o métodos para evaluarlos.

3. Evaluation theory driven evaluation /Evaluación sobre modelo teórico. Hay una necesidad de especificar/explicar con modelos cómo se espera que ocurran las intervenciones mediante una teoría de programa. La validez está dada en la claridad que tenga la teoría del programa.

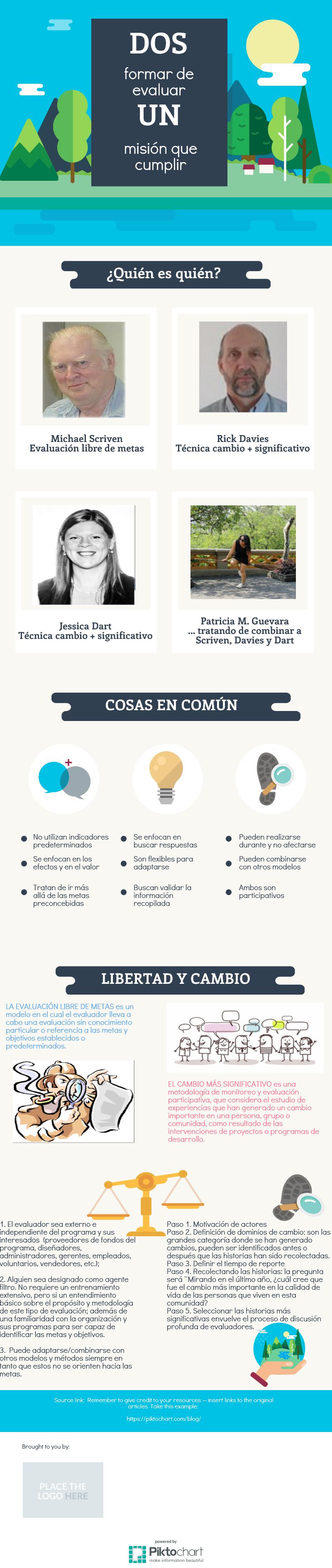

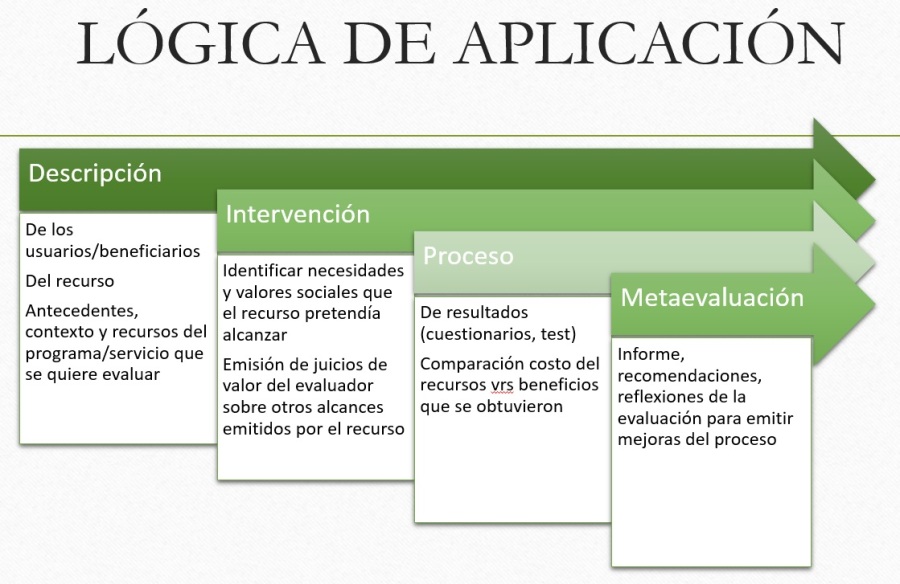

MICHAEL SCRIVEN

Actualmente, distinguido profesor de la División de Ciencias del Comportamiento y de organización de la U. Claremont Graduate, California.

Evaluación libre de metas (modelo de evaluación orientada al consumidor/cliente/usuario)

Evaluación independiente de los objetivos/metas es un modelo en el cual las metas u objetivos de un programa o proyecto son retenidos u ocultados desde el evaluador. Tiene las siguientes características:

- El evaluador evita al información relacionada a las metas

- Tampoco tiene metas preconcebidas para no fijar el foco de atención

- Se tiene un contacto mínimo con el staff o los miembros del programa

- Sin dicha información, el evaluador puede anticipar los efectos del programa

- Siendo así, entonces la evaluación libre de metas se enfoca en los efectos, no en el logro de las metas del PPPE

METODOLOGÍA NEUTRAL + TRES CONDICIONES:

- El evaluador sea externo e independiente del programa y sus interesados (proveedores de fondos del programa, diseñadores, administradores, gerentes, empleados, voluntarios, vendedores, etc.);

- Alguien sea designado como filtro; es decir, alguien que no está asignado GFE al diseño o la recogida de datos), tales como auxiliar administrativo, un tercero, o incluso el cliente de evaluación.

- Puede adaptarse/combinarse con otros modelos y métodos siempre en tanto que estos no se orienten hacia las metas.

Multimodelo en evaluación (Lista de control de indicadores):

- La descripción del programa

- El cliente que solicitó la evaluación

- Los antecedentes y el contexto del evaluando y la evaluación

- Los recursos disponibles (para viabilidad de una evaluación)

- La(s) función(es) del evaluando

- Los sistemas de distribución; es decir, cómo se acerca al usuario

- El usuario, sugiere distinguir entre población receptora directa e indirectamente afectada.

- Las necesidades, deseos y los valores de los afectados

- La normas existentes y previas (normativa legal sobre lo que se espera de lo que estamos evaluando)

- El proceso y sus limitaciones

- Los resultados.

- La posibilidad de generalizar

- Los costes

- La comparación con otras alternativas disponibles o no.

- Generar una síntesis de la información de los puntos 1 al 15.

- Generar recomendaciones.

- Generar un informe

- La meta-evaluación, una evaluación debe ser evaluada antes de su realización y antes de la difusión final de su informe.

La evaluación no se realiza solo para terminar con un programa o proyecto. La evaluación permite:

- Visualizar efectos secundarios

- Impulsar las potencialidades del proyecto o programa

- Posicionar un tema mediante la comunicación de la evaluación

- Validar externamente un programa o proyecto

- Dar voz a los involucrados/beneficiarios del programa o proyecto (esto dependerá del enfoque con que se realice la evaluación, por ejemplo: evaluación para el empoderamiento*)

En esta línea Ernest R. House propone una evaluación para la democracia, la cual debe buscar:

- La representación de una amplia gama de puntos de vista e intereses en los estudios de evaluación

- Fomentar la participación de los interesados en los procesos de evaluación

- Proporcionar oportunidades para la deliberación extendida

* No todo proceso participativo es para el empoderamiento.

TEORÍA E HISTORIA DE LA EVALUACIÓN:

La evaluación nace a partir de dos elementos claves: el rendimiento de cuentas y la investigación social, se busca responder con la investigación el rendimiento de cuentas.

Los primeros evaluadores dieron un énfasis al tema del método, se enfocaban en el instrumental metodológico, en los métodos sistemáticos.

Luego aparece otro grupo de evaluadores que empiezan a dirigir la atención a la valoración; es decir, a cómo emitir mejores juicios de valor.

Otro grupo de evaluadores esta enfocado en que las evaluaciones sean útiles y utilizadas.

Los otros autores latinoamericanos, asiáticos y africanos: están orientados/enfocados en la evaluación reflexiva.

EXPONENTES IMPORTANTES

LEE J. CRONBACH

Resumen, extractos y anotaciones de las lecturas:

Natalia Aquilino, Eva Arias, Sofía Estévez y Agustina Suaya. Hacia un análisis de evaluabilidad de planes y programas sociales: un estudio sobre 33 iniciativas

implementadas en Argentina. En: STUDIA POLITICÆ Número 34 ~ primavera-verano 2014/2015 Publicada por la Facultad de Ciencia Política y Relaciones Internacionales,

de la Universidad Católica de Córdoba, Córdoba, República Argentina.

1. ¿QUÉ ES EVALUABILIDAD?

Grado en el que las características particulares del diseño de un programa o plan afectan a la habilidad de proveer una evaluación efectiva (Youtie, Bozeman y Shapira, 1998).

Contar con políticas públicas diseñadas para ser monitoreadas y evaluadas con regularidad es un componente fundamental para fomentar el desarrollo de mejores intervenciones estatales

2. ¿QUÉ ES ANÁLISIS DE EVALUABILIDAD?

Es una herramienta estratégica de la evaluación de políticas públicas porque, entre otros motivos

Un proceso sistemático que permite identificar si un plan o programa (o incluso una organización) está en condiciones de ser evaluado, recomienda metodologías de evaluación

adecuadas a cada escenario particular y establece si su evaluación permitirá generar información útil y valiosa (Wholey, 1979; Rutman, 1980; Morras Imas y Rist, 2009).

3. ¿CUÁLES SON LOS USOS O UTILIDAD DE UN ANÁLISIS DE EVALUABILIDAD?

Información de alto valor estratégico y útil para mejorar la calidad, eficiencia y efectividad de las distintas políticas públicas.

Permite optimizar el presupuesto, evitando inversiones inadecuadas y justificaciones basadas en valoraciones concretas de los gastos

En contextos en los que la sociedad civil demanda resultados de gobierno y exige transparencia y rendición de cuentas, el monitoreo y la evaluación generan insumos robustos y confiables sobre el desempeño y el cumplimiento de los objetivos gubernamentales planeados.

4. ¿POR QUÉ ES IMPORTANTE UN ANÁLISIS DE EVALUABILIDAD?

El alcance y el tipo de evaluación posible están determinados por elementos que se relacionan, entre otras cosas, con el diseño de la intervención, los sistemas de información y recolección de datos articulados para realizar el seguimiento durante la implementación, los recursos humanos y operativos disponibles, las expectativas y beneficios esperados por los participantes y, en general, con la actitud de los implicados en el desarrollo de la intervención pública ante la evaluación. Las características específicas de estos elementos determinarán en cada caso la conveniencia de poner en marcha o no una evaluación

5. ¿QUÉ ES EL PROTOCOLO DE EVALUABILIDAD?

El protocolo de evaluabilidad permite familiarizar al evaluador con las características y el contexto de la política pública y facilitar el desarrollo de relaciones de colaboración con el personal administrativo.

Cuando la aplicación del protocolo indica que una evaluación es viable recomendará metodologías adecuadas al escenario; en casi de un resultado no viable/inviable dará recomendaciones acerca de cómo reacondicionar el programa para generar

las condiciones que viabilicen la evaluación.

6. ¿PASOS PARA CONSTRUIR UN PROTOCOLO DE EVALUABILIDAD?

- Revisión de la literatura

- Construcción de las dimensiones (VER PUNTO 7)

- Construccción de los indicadores cuantitativos y cualitativos, y preguntas-guías

- Legitimar el instrumento con grupos de expertos; grupos focales, entrevistas y encuestas a funcionarios de gobierno y académicos vinculados a la evaluación y a la implementación de programas sociales, con el fin de presentar el instrumento y someterlo a críticas.

7. ALGUNOS EJEMPLOS DE DIMENSIONES A CONSIDERAR EN UN ANÁLISIS DE EVALUABILIDAD

1. Calidad de la planificación y del diseño de la intervención para lograr los efectos deseados. Un aspecto de un buen diseño sería su evaluabilidad.

2. Calidad del sistema de información para realizar el seguimiento, la producción y el archivo de la información. Es decir, la accesibilidad de la información.

3. Estrategia de evaluación prevista en la formulación de la intervención. Uno de los factores que fortalecen la evaluabilidad es que la necesidad de realizar evaluaciones se instale explícitamente desde la etapa de diseño del programa: la evidencia demuestra que los planes nacionales que incluyen monitoreo y evaluación periódicos desde la planificación aumentan su capacidad para articularse con otros actores y producir sinergias. se consideran los siguientes indicadores: tipo de estrategia, propósitos y alcance, utilización de resultados y retroalimentación, difusión de hallazgos y sistematización de lecciones aprendidas

4. Estrategia de actores(grupos de interés y beneficiarios) adoptada para incluir la participación durante las diferentes etapas de seguimiento y evaluación. Así como, la previsión de la contratación de actores externos para realizar evaluaciones.

5. Recursos efectivos destinados para la realización de la evaluación (económicos, temporales y humanos).

Protocolo de evaluabilidad de la Comunidad Foral de Navarra

¿QUÉ ES ESPACIOS ABIERTOS/OPEN SPACES TECHNOLOGY?

Espacios abiertos es una técnica que permite trabajar temas complejos con grupos numerosos, en la cual se exponen todas las ideas, intereses o inquietudes. Un facilitador recoge los principales temas que los participantes han escrito o manifestado y quisieran discutir durante la sesión, posteriormente se sistematizan estos temas clasificándolos por orden de interés mayoritario, posteriormente y como resultado se logra conformar una agenda sobre la cual trabajar de forma espontánea y en subgrupos.

Se considera una tecnología emergente de participación para el trabajo de grupos grandes de alto desempeño y ha sido aplicada en varios campos con excelentes resultados. Según cita un artículo de la Revista SCIELO esta técnica como forma de trabajo permite:

crear un ambiente similar al que se da durante los recesos para tomar “el refrigerio” en un evento. La incertidumbre creada por el “aparente” caos proveen la libertad para crear, y el estado de apertura que se genera permite abordar mejor los temas y dar una mejor dirección… no es sólo un evento, es una nueva forma de trabajar, de pensar, de reunirse

Al final de la sesión, cada grupo de trabajo expone sus resultados en el tablón informativo, de modo que todos los participantes pueden acceder a esta información, independientemente del grupo donde estuvieron trabajando